AIのGPU輸出規制と性能解説:H100、B200、GB200の現状と中国・日本での活用

アメリカの輸出規制は、主に国家安全保障を理由に、中国をはじめとする特定の国への先進的なAI関連技術の輸出を制限するものです。

商務省の産業安全保障局(BIS)が管轄し、2022年10月以降、段階的に強化されてきました。2025年現在、規制の焦点はNVIDIAのH100、B200、GB200などの高性能GPUで、これらはAIモデルの訓練や推論に不可欠な計算能力を提供します。

規制の根拠は、Total Processing Performance (TPP)という指標で、4,800を超える性能のチップを制限対象としています。これにより、中国の軍事利用やAI開発の加速を防ぐ狙いがあります。

規制の歴史を振り返ると、2022年8月にA100とH100の輸出が最初に禁止され、2023年10月にはA800やH800などの中国向け調整版も対象に追加されました。2025年1月の「AI Diffusion Rule」では、グローバルなライセンス制度を導入し、第三国経由の迂回輸出を防ぐ枠組みが強化されました。

これにより、B200やGB200も影響を受け、輸出ライセンスが必要になりました。ただし、2025年7月にはトランプ政権下で一時的にH20の輸出が許可されるなど、政策の変動が見られます。NVIDIAはこれに対応し、中国市場向けに性能を落としたチップを開発していますが、全体として中国への供給は大幅に制限されています。

規制の対象国は中国、香港、マカオが主ですが、2025年の更新でロシアやイランにも拡大。TPPを超えるGPUは、ライセンスなしで輸出禁止となり、違反者は刑事罰の対象です。この規制は、米中技術競争の象徴として、NVIDIAの中国売上を13%(約171億ドル)から大幅に減少させました。

GPUのH100、B200、GB200の規制状況について

H100

H100はHopperアーキテクチャの主力GPUで、TPPが16,000と規制閾値の3倍以上を超えるため、2022年以降、中国への直接輸出が禁止されています。

2025年現在もこの状況は変わらず、ライセンス取得が極めて困難です。B200とGB200はBlackwellアーキテクチャの新世代で、2025年1月のAI Diffusion Ruleで明示的に規制対象に追加されました。

B200は単体でTPPが約20,000、GB200(B200 x2 + Grace CPUのスーパーチップ)はさらに高く、40,000を超えるため、中国輸出は事実上不可能です。

これらのGPUはAI訓練で不可欠で、H100はChatGPTのような大規模言語モデルの基盤を築きましたが、中国では入手が難しくなっています。NVIDIAの2025年SECファイリングでは、B200/GB200の中国輸出制限が売上影響を与える可能性を指摘し、55億ドルの損失を計上した事例もあります。規制はハードウェアだけでなく、サーバーシステム(例: DGX)やソフトウェアのエクスポートもカバーし、第三国経由の再輸出を防ぐためのVEU(Validated End-User)制度も運用されています。

中国などの当該国の実際のGPU利用状況

中国では、規制対象のH100、B200、GB200が地下市場や迂回ルートを通じて大量に流入し、軍事、大学、政府機関で活用されています。

2025年現在、中国は115,000台以上のHopper GPU(主にH100/H200)を39のAIデータセンターに展開予定で、新疆ウイグル自治区のYiwu郡だけで80,500台を計画中です。これはxAIのGrok 3訓練に使われたH100の約100,000台に匹敵する規模です。

ByteDance(TikTok親会社)はH100を16,000台、H800を60,000台保有し、海外拠点で20,000台以上のH100を運用。AlibabaやTencentも在庫を活用し、DeepSeekのR1モデルはH800で訓練され、「フロンティア級」性能を達成しました。

B200/GB200

B200/GB200の利用はまだ初期段階ですが、2025年7月の報告で、10億ドル以上のBlackwellチップが密輸され、深圳の修理工房でH100/A100のメンテナンスが月500台規模で行われています。中国軍や大学(例: 中国科学アカデミー)は入札文書でH100を調達し、2023年11月以降もSuper MicroやDellのサーバー経由で入手。

H20の禁止後、中古H100の需要が急増し、灰色市場で価格が下落(H100が数万ドルから2万ドル台へ)。これにより、中国のAI開発は規制の影響を最小限に抑え、HuaweiのAscend 910D(H100相当)とのハイブリッド運用が進んでいます。ただし、ソフトウェアのCUDA依存が強く、NVIDIAチップの優位性は残っています。

他の対象国(ロシア、イラン)では利用が限定的で、中国経由の再輸出が主。ロシアは2025年にH100を数百台入手し、軍事AIに活用していますが、規模は中国の10分の1以下です。

GPU 輸出の実態、ペナルティ、逮捕者の情報

輸出の実態は、密輸と迂回が主流です。2025年現在、シンガポールやマレーシアを中継地に使い、偽装ラベルや架空企業でH100を中国へ送るケースが横行。Financial Timesの調査で、10億ドル以上のBlackwellチップが2025年前半に密輸され、GB200サーバー(重量2トン)すら陸路で運び込まれました。

深圳の地下市場ではH100の修理が活発で、ファンレースやHBM交換で1台あたり2,800ドル。NVIDIAの供給過多在庫が第三国で転売され、中国企業が暗号通貨で匿名購入するパターンも増加しています。

ペナルティは厳しく、輸出管理法違反で最大20年の懲役と100万ドルの罰金、企業には数百万ドルの民事罰金が科されます。

2025年8月、Chuan Geng(28歳)とShiwei Yang(28歳)の中国系米国人が逮捕され、ALX Solutions社を通じて2022年10月〜2025年7月にH100を2億ドル分密輸した疑いで起訴。Super Microから200台以上を購入し、シンガポール/日本を偽装先として中国へ転送。2023年の請求書で2,845万ドルのH100がシンガポール行きと偽り、実際は存在しない企業宛でした。DOJは「密輸は非現実的」と強調し、NVIDIAも「非推奨」とコメント。

他の事例として、2025年2月のシンガポール警察がDeepSeek向けH100密輸リングを摘発、2024年12月の北京企業主Su DiがH200 200台をDouyinで自慢し当局調査。2025年4月にはHuaweiのAscend 910DがH100相当性能で市場投入され、密輸依存を減らす動きも。全体で、2025年の摘発件数は前年比50%増え、DOJのSupermicro調査も進行中です。

中国企業がアメリカやその他の国で最新GPUを利用することの問題点

中国企業が米国や同盟国でNVIDIA GPUを利用するのは、法的には可能ですが、厳格な条件付きです。

輸出規制は物理的な輸出を対象とし、米国内のデータセンターで中国企業がクラウド経由でGPUをレンタルするのは合法です。ByteDanceはOracle経由でH100を米国で使用し、Alibaba/TencentはNVIDIAと米データセンター構築を協議中。

2025年現在、中国テレコムも同様の提携を模索しています。理由は、規制が「エンドユーザー」指定を主とし、米国内利用はBISのライセンス不要だからです。

しかし、問題点は複数あります。まず、米政府の「外国敵対者投資審査(CFIUS)」で、中国企業による米データセンター買収が審査対象となり、2025年1月のAI Diffusion Ruleで第三国経由の迂回を防ぐグローバルライセンスが導入されました。

ByteDanceのTikTokデータは米サーバーで処理されますが、軍事転用リスクで監視強化。欧州や日本でも、EUの「Green Deal」や日本の「経済安全保障推進法」で、中国企業へのGPU供給に制限がかかり、KDDIのAIデータセンターは中国提携を避けています。

実務的に、NVIDIAは「知りうる限り違法再販を防ぐ」とし、使用契約でエンドユーザー証明を義務付けますが、違反時は契約解除や法的措置。2025年の事例で、中国企業が米クラウドでH100を使い、データ漏洩疑惑でOracleが調査を受けました。結論として、合法ですが、セキュリティ審査と契約遵守が鍵で、無制限とは言えません。将来的に、米中緊張で米国内利用すら制限される可能性があります。

日本のデータセンターで利用契約して活用することの問題点

日本でのNVIDIA GPU利用は、輸出規制の対象外で全く問題ありません。

日本は米国との同盟国(QUAD)として、2025年現在、H100、B200、GB200を自由に輸入・運用可能です。SoftBankは2025年にDGX SuperPODを導入し、10,000台以上のB200で13.7エクサフロップスを達成。GMO InternetやKDDIもH100を数千台展開し、ABCI-QスーパーコンピューターはH100 2,000台で量子AI研究を推進。高resoの香川データセンターは1,600台のNVIDIA GPUを稼働中です。

問題点はほぼなく、むしろ日本政府の「AI戦略2025」で補助金が出され、電力供給(2025年2.32GW→2030年3.66GW)が後押し。

Google Cloudの千葉データセンターはB200/GB200を導入し、液冷システムで効率化。輸出規制の影響は中国迂回防止のみで、日本企業はNVIDIAと直接契約可能。コスト面でH100の時間単価が2.85ドル/時と低下し、導入障壁が低いです。唯一の懸念はグローバル供給不足ですが、TSMCの日本工場拡大で安定供給が見込まれます。個人/企業はXserverなどのプロバイダでGPUインスタンスを契約でき、AI活用が容易です。

各GPUの性能の簡単な説明

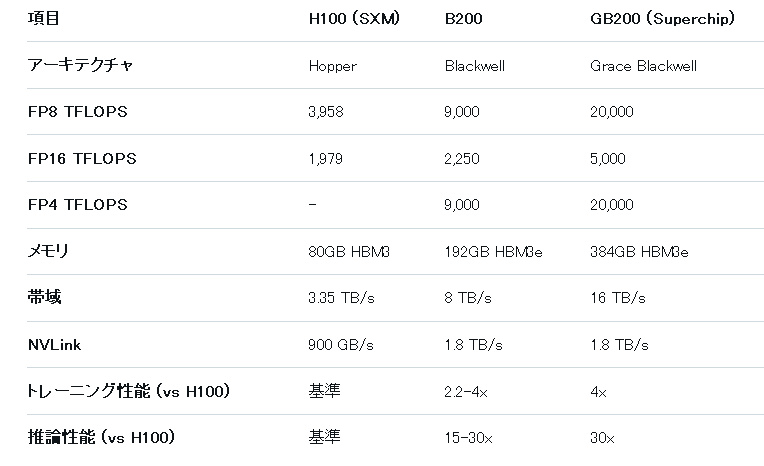

NVIDIAのGPUはAI/HPC向けに進化し、H100/B200/GB200は大規模モデル訓練に特化。中国向け調整版は性能を落としています。以下、各GPUの主なスペックと特徴を比較します。

xaiによる図表

・ H100 (Hopperアーキテクチャ、2022年発売)

TSMC 4Nプロセス、SXM/PCIe版あり。FP8 Tensor Coreで1,979 TFLOPS、HBM3 80GB(帯域3.35TB/s)、TDP 700W。AI訓練でA100の6倍、推論で30倍高速。TPP 16,000で規制対象。中国では密輸で利用され、MLPerfで大規模LLM訓練の標準。

・ B200 (Blackwellアーキテクチャ、2025年発売)

TSMC 4NPプロセス、チップレット設計(2ダイ統合)。FP4で20 PFLOPS、HBM3e 192GB(帯域8TB/s)、TDP 1,000W。H100比で訓練2.5倍、推論15倍。DGX B200システムで3倍訓練効率。液冷必須で、エネルギー効率25%向上。TPP 20,000超で中国禁止。

・ GB200 (Blackwellスーパーチップ、2025年発売)

B200 x2 + Grace CPU統合、NV-HBI 10TB/s接続。FP4で40 PFLOPS、HBM3e 384GB + LPDDR5X 480GB(総864GB)、TDP 2,700W。NVL72ラックで72 GPU、30倍推論。H100比で訓練5倍、推論30倍。2トン級サーバーで、xAIのGrok訓練に相当する規模。

・ 中国向け性能落としのGPU

A800 (Ampere調整版)

A100の70%性能(FP64 6.8 TFLOPS、BF16 437 TFLOPS)、NVLink 400GB/s(標準600GB/sの67%)。HBM2e 40/80GB。規制遵守で中国専用、訓練効率40%低下もCUDA互換で人気。価格1万ドル超。

・ 中国向け性能落としのGPU

H800 (Hopper調整版)

H100の半分NVLink(300GB/s)、FP64 1 TFLOPSに低下。HBM3 80GB、TDP 700W。推論20%高速だが訓練遅延増。中国でH100代替、DeepSeek R1で活用。2025年禁止後、中古H100へシフト。

・ 中国向け性能落としのGPU

H20 (Hopper調整版、2025年Q2)

H100の15-30%性能(FP16 296 TFLOPS)、TPP 4,800以内に抑え。HBM3 96GB、帯域1TB/s。推論特化でCUDA完全互換。中国で100万台以上在庫、2025年7月一時許可も北京警告でセキュリティ懸念。

これらのGPUは、精度(FP64高精度科学計算 vs FP4低精度AI推論)で用途が分かれ、Blackwellはメモリ/帯域強化で大規模モデルに最適。中国版は相互接続制限でスケーラビリティ低下します。

全体の展望

米国のGPU輸出規制は2025年現在、AI覇権争いの核心で、中国の密輸実態がその限界を示しています。

H100/B200/GB200の性能進化は目覚ましく、日本のような同盟国では活用が加速。一方、中国企業は米国外利用で抜け道を探りますが、グローバル監視強化で持続可能性が課題。NVIDIAの中国市場売上減少は55億ドル超ですが、BlackwellのTCO向上(H100比47%効率化)が業界を変革します。将来的に、量子耐性や持続可能冷却が鍵となり、技術の民主化が進むでしょう。